結合エントロピーとは?性質と具体例、例題について

1. 結合エントロピー

結合エントロピー(joint entropy)とは、2つ以上の確率変数の情報量を測る指標です。

\[ H(X, Y) = – \sum_{x \in X} \sum_{y \in Y} p(x, y) \log_2 p(x, y) \]

ここで、\( p(x, y) \) は \( X \) と \( Y \) の同時確率です。

\[ H(X, Y) = \mathbb E_{p}[I(X,Y)] \]

2. 結合エントロピーの性質

2.1. 結合エントロピー

$$H(X,Y)=H(X)+H(Y)$$

独立であることから$p(x, y)=p(x)p(y)$より、結合エントロピーの式を変形すると、

\[ \begin{aligned} H(X, Y) &= – \sum_{x \in X} \sum_{y \in Y} p(x, y) \log p(x, y) \\ &= – \sum_{x \in X} \sum_{y \in Y} p(x) p(y) \log \left( p(x) p(y) \right) \\ &= – \sum_{x \in X} \sum_{y \in Y} p(x) p(y) \left( \log p(x) + \log p(y) \right) \\ &= – \sum_{x \in X} \sum_{y \in Y} p(x) p(y) \log p(x) – \sum_{x \in X} \sum_{y \in Y} p(x) p(y) \log p(y) \\ &= – \sum_{x \in X}p(x)\log p(x) \sum_{y \in Y} p(y) – \sum_{x \in X} p(x) \sum_{y \in Y} p(y) \log p(y) \end{aligned} \]

ここで、$\sum_{y \in Y} p(y)=\sum_{x \in X} p(x)=1$となるので、

$$\begin{aligned} H(X, Y) &= – \sum_{x \in X}p(x)\log p(x) \sum_{y \in Y} p(y) – \sum_{x \in X} p(x) \sum_{y \in Y} p(y) \log p(y) \\ &= – \sum_{x \in X}p(x)\log p(x) – \sum_{y \in Y} p(y) \log p(y) \\ &=H(X)+H(Y) \end{aligned}$$

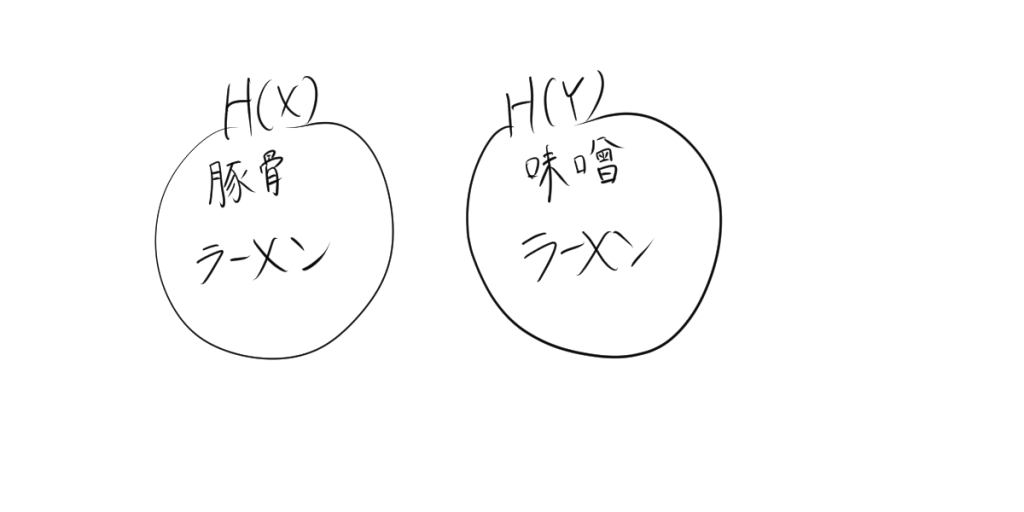

具体例を考えてみます。仮に、豚骨ラーメンを食べることで知ることができる情報量を$H(X)$とします。一方で、味噌ラーメンを食べることで知ることができる情報量を$H(Y)$とします。ここで、メニューに味噌豚骨ラーメンはないとします。図にすると、

メニューに味噌豚骨ラーメンがないので、この両方を食べて知ることができる情報量$H(X,Y)$は$H(X)+H(Y)$となります。

メニューに味噌豚骨ラーメンがないので、この両方を食べて知ることができる情報量$H(X,Y)$は$H(X)+H(Y)$となります。

2.2. 独立でないとき

相互情報量 \( I(X; Y) \) を利用します。

\[ I(X; Y) = H(X) + H(Y) – H(X, Y) \]

また、相互情報量は常に非負であるため、

\[ I(X; Y) \geq 0 \]

これを上の式に代入すると、

\[ H(X) + H(Y) – H(X, Y) \geq 0 \]

したがって、

\[ H(X, Y) \leq H(X) + H(Y) \]

となります。

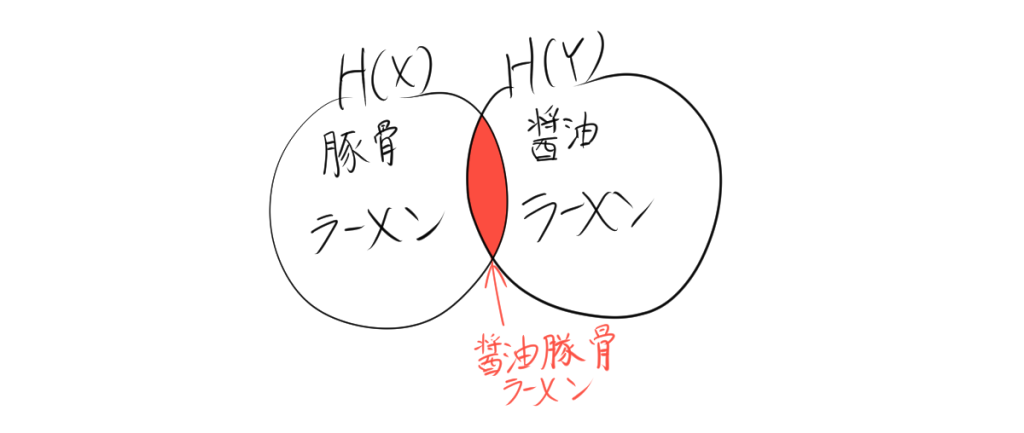

具体例を考えてみます。仮に、豚骨ラーメンを食べることで知ることができる情報量を$H(X)$とします。一方で、しょうゆラーメンを食べることで知ることができる情報量を$H(Y)$とします。ここで、メニューに醤油豚骨ラーメンがあるとします。図にすると、

$H(X,Y)$は$H(X)+H(Y)$でないことがわかります。

3. 例題:ラーメン店の人気具材

- チャーシューを注文する確率 \(P(C) = 0.6\)

- メンマを注文する確率 \(P(M) = 0.4\)

- 両方の具材を注文する確率 \(P(C, M) = 0.25\)

この情報を使って、チャーシューとメンマの結合エントロピー \(H(C, M)\) を求めてください。

結合エントロピーの計算に必要な確率を以下のように考えます。

- 両方を注文する確率 $$P(C, M) = 0.25$$

- チャーシューのみを注文する確率 $$P(C, \neg M) = P(C) – P(C, M) = 0.6 – 0.25 = 0.35$$

- メンマのみを注文する確率 $$P(\neg C, M) = P(M) – P(C, M) = 0.4 – 0.25 = 0.15$$

- どちらも注文しない確率 $$P(\neg C, \neg M) = 1 – P(C) – P(M) + P(C, M) = 1 – 0.6 – 0.4 + 0.25 = 0.25$$

結合エントロピー \(H(C, M)\) の式は次の通りです。

\[ H(C, M) = -\sum_{c \in \{C, \neg C\}} \sum_{m \in \{M, \neg M\}} P(c, m) \log_2 P(c, m) \]

各確率に対して計算を行います。

- \(P(C, M) = 0.25\)より、 \[P(C, M) \log_2 P(C, M) = -0.25 \log_2 0.25 \]

- \(P(C, \neg M) = 0.35\)より、\[P(C, \neg M) \log_2 P(C, \neg M) = -0.35 \log_2 0.35 \]

- \(P(\neg C, M) = 0.15\)より、 \[P(\neg C, M) \log_2 P(\neg C, M) = -0.15 \log_2 0.15 \]

- \(P(\neg C, \neg M) = 0.25\)より、\[P(\neg C, \neg M) \log_2 P(\neg C, \neg M) = -0.25 \log_2 0.25 \]

結合エントロピー \(H(C, M)\) を求めるために、それぞれを合計します。

\[ H(C, M) = -0.25 \log_2 0.25 – 0.35 \log_2 0.35 – 0.15 \log_2 0.15 – 0.25 \log_2 0.25\approx 1.94 \]